Redis实现海量精确去重的技术实践(redis海量精确去重)

Redis实现海量精确去重的技术实践

在海量数据处理业务中,去重是一项非常重要的工作,因为存在大量重复数据会造成计算、存储等方面的负面影响。为了高效地解决这个问题,使用Redis实现海量精确去重是一种可行的方案。

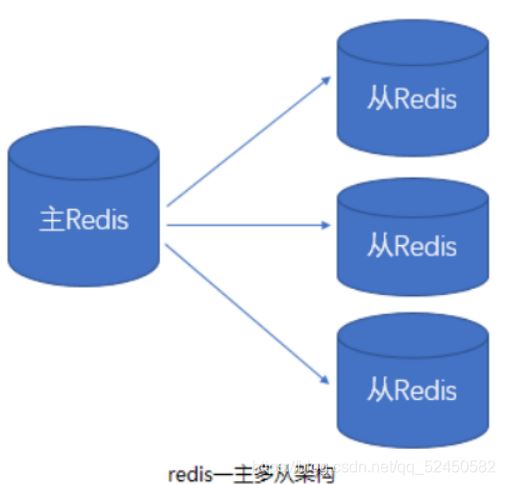

Redis是一个高性能的NoSQL数据库,它的内存读写速度非常快。它不仅支持存储不同类型的数据,而且提供了各种丰富的数据结构,如字符串、哈希表、列表、集合和有序集合等。这些数据结构可以帮助我们快速地进行数据处理,包括去重,Redis集合数据结构的优点在于去重时间复杂度为O(1)。

下面我们将介绍如何使用Redis实现海量精确去重。

我们需要连接Redis数据库,并创建一个新的集合。代码如下:

import redis

r = redis.Redis(host=’localhost’, port=’6379′, db=0)

r.delete(‘unique_data’) #delete the set if it exists before

unique_data = r.sadd(‘unique_data’, ‘value1’, ‘value2’, ‘value3’)

在这个代码片段中,我们创建了一个名为“unique_data”的新集合,并添加了三个值。如果该集合已经存在,则将其删除,并重新创建。这样可以确保我们从零开始创建集合。

接下来,我们需要实现一个函数,该函数可以将新数据插入集合中,并确保它不会重复存在。代码如下:

def insert_data(data):

if r.sismember(‘unique_data’, data):

print(data, ‘already exists’)

else:

r.sadd(‘unique_data’, data)

print(data, ‘added successfully’)

在这个代码片段中,我们使用了“sismember”命令来判断输入数据是否已经存在。如果数据不存在集合中,则使用“sadd”命令将其插入,并输出结果。

我们需要测试我们的代码。我们可以使用Python的随机模块生成一些随机数据。代码如下:

import random

for i in range(10):

data = ‘data_’ + str(random.randint(1, 5))

insert_data(data)

在这个代码片段中,我们生成了10条随机数据,并使用“insert_data”函数将它们插入到集合中。因为我们只随机生成了1到5之间的数,所以有些数据是重复的,但是我们的代码能够正确地过滤掉这些重复数据。

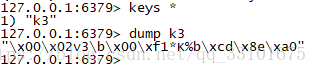

当我们运行完上面的代码后,我们可以使用“smembers”命令查看集合中已有的数据。代码如下:

print(r.smembers(‘unique_data’))

输出结果:

{b’data_1′, b’data_2′, b’data_3′, b’data_4′, b’data_5′}

从结果中可以看出,我们的代码已经正确地将数据插入到了集合中,并将重复数据去除。

总结

在这篇文章中,我们介绍了Redis的集合数据结构,并演示了如何使用Python和Redis实现海量精确去重。这个方法可以帮助我们在处理海量数据时更高效地去除重复数据。如果你正在处理大规模的数据集,那么这种方法或许可以为你提供一些思路。