淘汰缓存,更新计算Redis实现方式(redis淘汰的计算方法)

淘汰缓存,更新计算:Redis实现方式

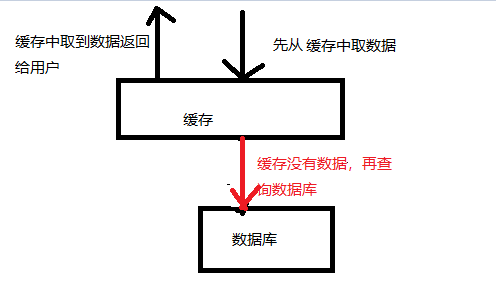

随着数据量不断增长,缓存逐渐成为了提高应用性能的必要手段。然而,在使用缓存的过程中,我们也需要考虑到清除过期缓存、避免缓存雪崩等问题。这时,在缓存的使用中,我们不得不考虑到Redis的作用。

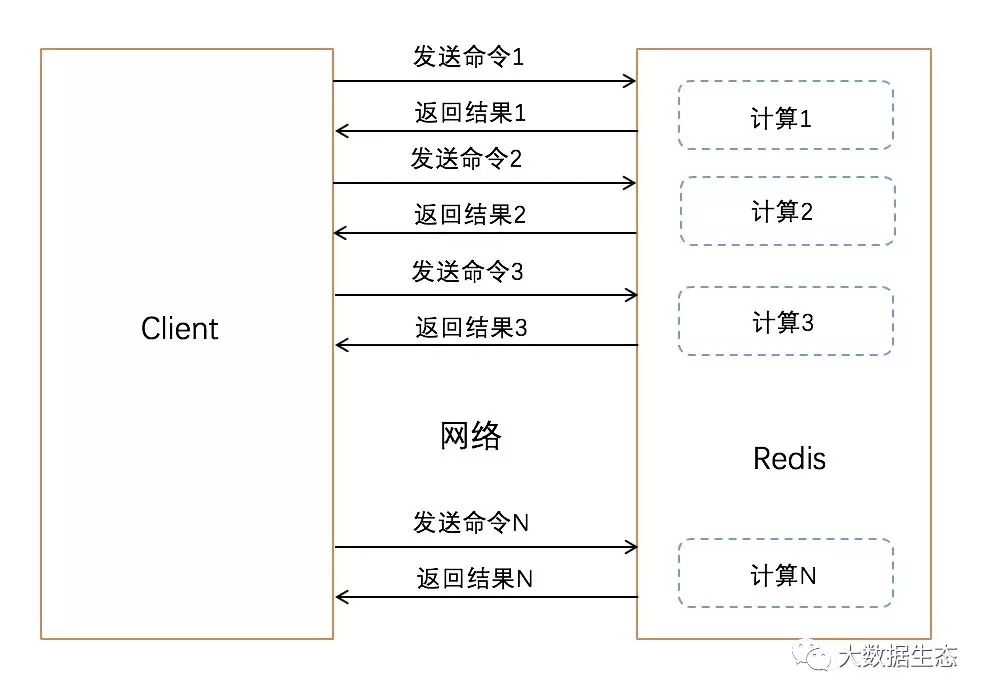

Redis是一款高性能的键值存储系统,支持丰富的数据结构,并且可以快速读写数据。在大规模应用场景中,Redis可以作为缓存架构的核心组件,来实现数据快速读取和更新。同时,Redis还支持各种高级操作,如发布/订阅、事务、持久化等,使得应用程序的开发更加灵活多变。

在使用Redis实现淘汰缓存、更新计算时,我们通常采取以下几种方式:

1.基于TTL(Time-To-Live)机制的缓存过期处理

在Redis中,可以通过设置TTL值,来控制缓存的有效期。当缓存项的TTL值到期后,Redis会自动将其从缓存中清除。这种方式可以自动管理缓存过期,避免了缓存穿透和缓存雪崩的问题。同时,这种方式可以根据不同的业务需求,灵活地调整缓存的有效期。

以下是基于TTL机制的缓存淘汰示例:

“`python

# 设置缓存key值和TTL(10秒)

# 如果缓存key不存在,则创建一个新的缓存项

# 如果缓存key已存在,则更新其TTL值为10秒

def add_data_to_cache(key, value):

if not cache.get(key):

cache.set(key, value, ttl=10)

else:

cache.set(key, value, ttl=10)

# 缓存key为“foo”对应的value值为“bar”,TTL为10秒

add_data_to_cache(“foo”, “bar”)

2.基于LRU算法的缓存淘汰处理

在Redis中,可以通过使用最近最少使用(LRU)算法,来实现缓存的淘汰处理。LRU算法的基本思想是,当缓存空间不足时,优先将最近最少使用的缓存项清除。这种方式可以根据缓存项的访问状况,动态更新其缓存优先级,以实现高效的缓存淘汰。

以下是基于LRU算法的缓存淘汰示例:

```python# 设置缓存key值

# 如果缓存已满,则根据LRU算法,删除最近最少使用的缓存项def add_data_to_cache(key, value):

if cache.full(): cache.delete(cache.lru())

cache.set(key, value)

# 缓存key为“foo”对应的value值为“bar”add_data_to_cache("foo", "bar")

3.基于Redis的增量计算

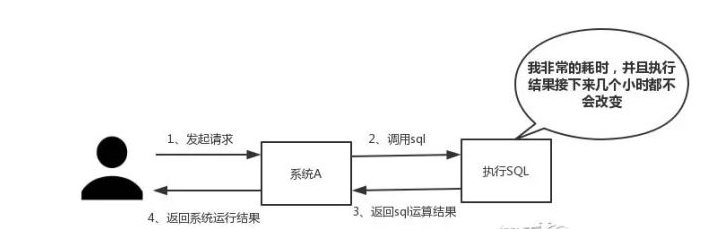

在大规模数据处理中,我们需要针对海量数据进行计算,而这种计算过程往往是十分缓慢的。在这种情况下,我们可以使用Redis的增量计算功能,将数据计算结果存储在缓存中,以提高应用程序的性能。增量计算的基本思想是,将数据按照一定规则分成若干段,并将这些段分别进行计算和存储。当需要查询数据时,只需要将这些段的计算结果合并即可。

以下是基于Redis的增量计算示例:

“`python

# 定义增量计算函数

# 将数据分成10个段,并分别计算每个段的求和值

def incremental_sum(data):

results = []

chunk_size = 10

for i in range(0, len(data), chunk_size):

chunk_data = data[i:i + chunk_size]

chunk_sum = sum(chunk_data)

# 将每个段的计算结果存入缓存中

results.append(cache.set(f”chunk{i}”, chunk_sum))

# 查询所有段的计算结果,并将其合并

return sum([cache.get(f”chunk{i}”) for i in range(0, len(data), chunk_size)])

# 计算列表data的求和结果,并将其结果存入缓存中

data = [1, 2, 3, 4, 5, 6, 7, 8, 9, 10, 11, 12, 13, 14, 15]

result = incremental_sum(data)

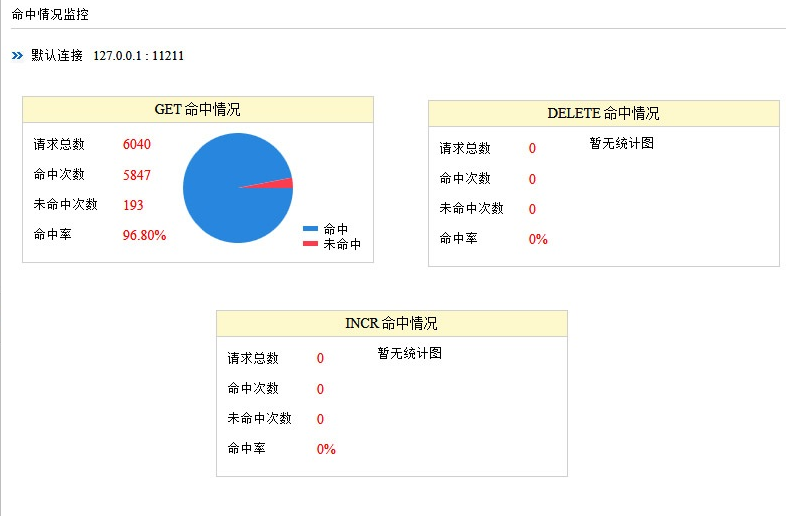

Redis在处理增量计算和缓存淘汰方面具有明显的优势。通过配置合适的缓存结构和算法,我们可以在Redis的帮助下,极大地提高应用程序的性能,提升用户体验。