激发活力使用Spark设置Redis(spark设置redis)

Spark是一款免费开源的分布式计算框架,它可以用来激发应用程序和服务的活力。它通过处理、组织和存储数据来加速工作流程,帮助开发人员更快地完成开发任务。与其他框架相比,Spark的最大优势是支持Redis的配置功能,可以对Redis进行大规模的分布式存储。

1. 准备

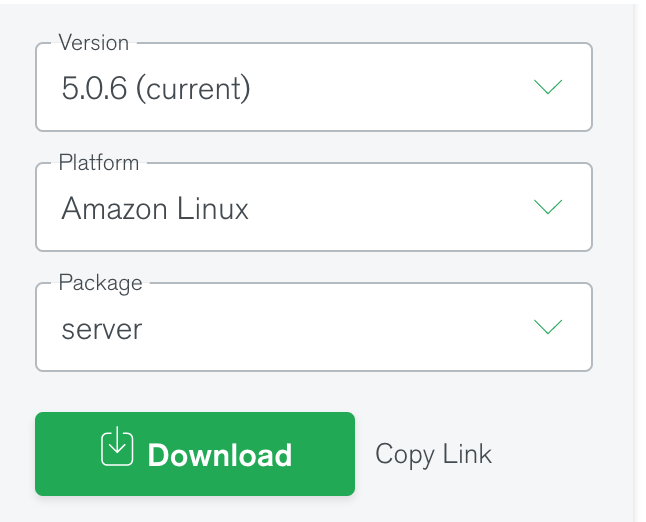

为了启用Spark,首先需要准备一台服务器。安装Spark,并且为该服务器配置所需要的资源(例如内存)和软件(例如Apache Hadoop)。然后,需要安装并配置Redis服务器。

2. 使用Spark设置Redis

启动Spark,然后在终端中输入spark-shell命令。这将进入Spark中的交互式shell环境,可以在其中运行Spark脚本。让我们以一个简单的例子来说明如何使用Spark与Redis进行交互:

//创建一个Spark连接

val spark = SparkSession .builder

.config("spark.redis.host", "127.0.0.1") .config("spark.redis.port", "6379")

.getOrCreate()

//创建一个Redis连接val redis = new RedisClient("127.0.0.1", 6379)

//接下来可以使用spark和redis对象的API来查询数据

3. 使用Spark读取和写入数据

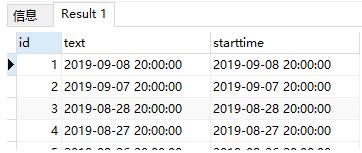

使用Spark可以读取各种Redis存储的数据类型,例如字符串、列表、集合和哈希表。在读取数据时,可以使用Spark SQL提供的查询语言来查询数据:

//例如:读取字符串类型的数据

val stringData = spark.read .format("org.apache.spark.sql.redis")

.option("key.columns", "key") .load("string.data")

//数据可以使用Spark提供的转换API来处理val filteredData = stringData.filter(stringData("key").startsWith("prefix"))

//查看数据结果filteredData.show()

//也可以使用API写入数据filteredData.write

.format("org.apache.spark.sql.redis") .option("key.columns", "key")

.save("string.data")

Spark提供了一种有效的方式来处理Redis数据,从而改善应用程序和服务的性能和效率。使用Spark可以读取、分析和写入Redis数据,帮助开发人员快速掌握和激发应用程序的活力。